Repère historique

Cet article a été publié à une époque où comprendre pourquoi un site n’apparaît pas sur Google impliquait d’analyser des facteurs techniques, structurels et de référencement propres aux moteurs de recherche classiques. Il visait à décomposer les éléments les plus courants qui pouvaient empêcher l’indexation ou l’affichage d’un site dans les résultats traditionnels.

Il est ici conservé comme ressource documentaire permettant d’appréhender les mécanismes qui guidaient alors la visibilité des sites web dans les moteurs de recherche avant l’avènement des systèmes de réponse IA.

Après tout le mal que vous vous êtes donnés à créer un site ergonomique et agréable à parcourir, à passer des heures à rédiger l’article ultime, le constat est accablant : votre site web n’apparaît pas dans les résultats de recherche de Google ! Oh rage, oh désespoir !

Mauvaise nouvelle : effectivement, générer du trafic organique sera très compliqué. La bonne nouvelle : ce n’est pas inéluctable. Les raisons de cette absence au sein des résultats de recherche de Google, les fameux SERP, peuvent être nombreuses. Mais d’expérience, ce sont souvent les mêmes qui reviennent.

Pour vous aider à corriger ce problème, nous vous proposons de procéder par élimination. Tout d’abord, reportez-vous aux deux grands cas de figure à savoir dans quelle situation vous vous trouvez. Mais tout d’abord, vérifions ensemble si votre site est bien absent des résultats de recherche.

Sommaire de cet article :

- Comment savoir si votre site est référencé par Google ?

- Cas n°1 : votre site, tout neuf, vient juste d’être publié

- Cas n°2 : votre site était déjà présent sur Google

- Nos conseils pour bien apparaître sur Google

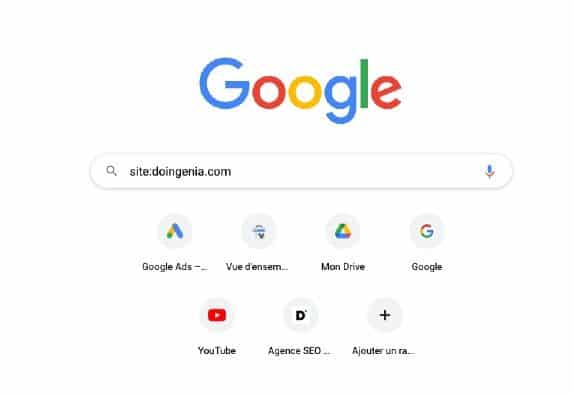

Comment savoir si votre site est référencé par Google ?

Une vérification s’impose avant tout. Dans notre métier, il n’est pas rare d’entendre un client dire : “Je ne trouve pas mon site quand je tape son nom dans Google !”.

Êtes-vous bien certain qu’aucune des pages web de votre site n’a été répertoriée par le moteur ? Il se peut très bien que votre site soit bien présent dans l’index, mais qu’il apparaisse très loin dans les SERP. Ce qui est un tout autre problème. Il peut également l’avoir exploré mais ne pas souhaiter l’intégrer à son index.

Vérifions donc avec la commande suivante : site:votrenomdedomaine.com

A partir de là, plusieurs possibilités :

- Aucune page ne ressort : l’ensemble des pages de votre site n’a pas encore été indexée dans l’immense base de données de Google

- Seulement une partie des pages a été indexée : plusieurs raisons peuvent expliquer cela. Nous les voyons en détail dans cette section. A COMPLETER

- Toutes les pages attendues sont bien indexées : bravo ! Vous avez très fait votre travail et n’aurez probablement pas besoin de lire la suite de cet article.

La commande site:votrenomdedomaine n’a rien donné ? Vous pouvez passer au chapitre suivant et de découvrir les réponses à votre question existentielle : « pourquoi mon site n’apparait pas dans google ?.

Cas n°1 : votre site, tout neuf, vient juste d’être publié

Les webmasters en herbe (et même certains professionnels malheureusement) font parfois quelques boulettes lors du lancement d’un nouveau site.

La plus fréquente est la suivante : l’oubli de la balise Meta “NOINDEX”. Résultat : le site entier n’apparaît pas sur Google.

L’indexation est volontairement bloquée par une balise NOINDEX

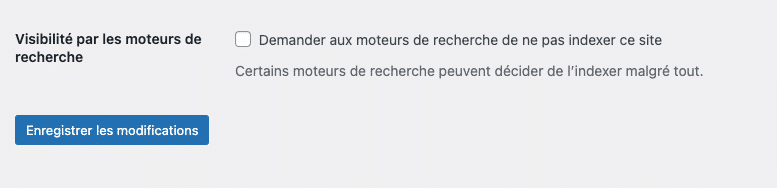

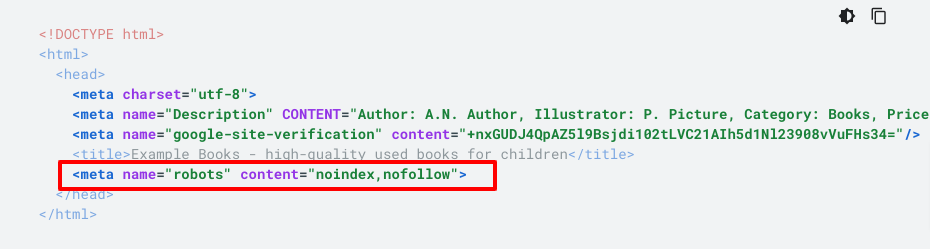

Arrêtons-nous sur le cas particulier du site WordPress qui n’apparaît pas sur Google après sa mise en ligne. Les possesseurs d’un site WordPress se reconnaîtront probablement dans les lignes qui vont suivre.

Dans les réglages du CMS WordPress (Réglages > Lecture), il existe une option nommée “Demander aux moteurs de recherche de ne pas indexer ce site”. Si cette case a été cochée, WordPress insère une balise “<meta name= »robots » content= »noindex »>” dans l’entête HTTP du site qui aura pour conséquence de bloquer l’indexation.

En effet, il est fréquent de constater qu’un site WP en préproduction comporte cette case cochée pour éviter que les pages du site ne se retrouvent sur Google. Néanmoins, la désactivation de cette option est souvent oubliée lors du passage en production.

Si votre site n’est pas un WordPress, il se peut également qu’une balise Meta “noindex” ait été oubliée. Dans ce cas, vérifiez le code source de plusieurs pages de votre site et rendez-vous en haut du code HTML à l’intérieur de la balise.

Pour résoudre le problème, il suffit simplement de remplacer la directive “noindex” par “index”. Si le robot d’exploration de Google peut accéder à votre site, il pourra ainsi décider ou non de l’ajouter à son index.

L’accès aux robots d’exploration est bloqué dans le fichier robots.txt

Avant même de décider d’intégrer ou non une page à son index, Google comme d’autres moteurs de recherche doit l’explorer. Mais vous pourriez très bien interdire aux crawlers d’accéder à votre site à l’aide du fichier robots.txt.

Ce fichier, présent à la racine d’un domaine et accessible avec une adresse de type “votredomaine.com/robots.txt” sert généralement à restreindre l’exploration de certains types de fichiers ou répertoires entiers.

La présence d’une ou plusieurs directives “Disallow” pourrait expliquer votre problème.

Par conséquent, si ce dernier a été mal configuré ou comporte des erreurs de syntaxe, il se peut que le crawler n’ait même pas eu l’occasion de parcourir votre site.

- Afin de vous assurer que le fichier robots.txt ne bloque pas le crawl, deux possibilités s’offrent à vous :

- Mettre à jour le contenu en autorisant tous les robots. Soumettre le sitemap XML de votre site sur la Google Search Console puis attendre quelques jours en surveillant le rapport de couverture

Testez le fichier existant à l’aide de l’outil de test de balisage du fichier robots.txt fourni par Google dans l’ancienne version de la Search Console : https://support.google.com/webmasters/answer/6062598?hl=fr

Pour les personnes dont le site a été créé avec le CMS le plus populaire au monde, nous proposons un article délivrant quelques astuces pour optimiser le fichier Robots.txt pour WordPress.

Le crawler est venu mais l’indexation n’a pas eu lieu

Vous n’êtes dans aucun des deux cas mentionnés ci-dessus. Après vérification, rien ne semble bloquer ni le crawl ni l’indexation, mais votre site n’apparaît toujours pas dans les résultats de Google.

Première explication possible : le robot de Google est passé mais n’a pas pu parcourir l’intégralité du site Internet. Parfois, un problème de serveur peut compliquer la tâche au robot.

A la question “Pourquoi ma page ne figure-t-elle pas dans les résultats de recherche Google ?”, le moteur précise lui-même que l’indexation peut mettre de plusieurs jours à plusieurs semaines.

Pour accélérer le processus, voici quelques conseils que vous pourrez retrouver dans la vidéo d’Olivier Andrieu ci-dessous :

- Soumettre un sitemap : au format XML, RSS ou texte, ce fichier doit comprendre l’ensemble des URL publiés sur le site web et que vous souhaitez référencer.

- Envoyer une demande d’indexation de la page d’accueil du site : avec une bonne navigation et la présence de liens pointant vers les pages les plus importantes du site, Google aura plus de facilité à l’explorer

- Ajouter un plan de site HTML : accessible depuis la page d’accueil, cette page jouera le même rôle que le sitemap et permettra en bonus de partager la popularité de la homepage avec les pages contenues dans le plan de site

Le site n’est pas accessible

Comme nous l’avons indiqué plus haut, il suffit que le site ne soit pas accessible au moment où le crawler arrive pour que cela retarde ou bloque tout le processus..

Vérifier les points suivants permettra de balayer tout problème d’origine technique :

- Le serveur d’hébergement fonctionne correctement : il arrive que les hébergeurs procèdent à des maintenances serveurs ou qu’ils aient à faire face à des pannes importantes. De nombreux hébergeurs fournissent des informations sur la santé et l’état de fonctionnement du serveur sur lequel est hébergé un site.

- Toutes les pages du site sont accessibles : parfois, une petite erreur de code pour empêcher l’affichage de tout un site ou certaines pages. Pour être sûr que le site fonctionne, insérez plusieurs URL (et pas seulement celui de la homepage) dans un navigateur. Répétez l’opération depuis un autre terminal : mobile, ordinateur du bureau.

- L’accès au site n’est pas restreint par l’insertion d’un mot de passe : bonne pratique pour le développement de site Internet, l’ajout d’un HTPASSWD permet de limiter l’accès à un site aux seuls détenteurs d’un utilisateur et d’un mot de passe. Toutefois, cette restriction doit être levée lors de la mise en ligne du nouveau site.

Cas n°2 : votre site était déjà présent sur Google

Examinons maintenant des problèmes bien plus épineux : l’absence dans l’index principal ou pire, la disparition pure et simple des SERP. Que ce soit après une refonte ou la mise à jour d’un algorithme de Google, les pages d’un site stagnent dans les bas-fonds des résultats de recherche.

Plusieurs raisons possibles à cela : un mauvais référencement naturel ou une pénalité infligée pour infractions aux consignes déterminées par la firme américaine.

Une mauvaise stratégie SEO

Qu’il s’agisse d’une petite boutique en ligne dont le trafic organique n’a jamais décollé ou d’un blog, les mêmes causes entraînent souvent les mêmes effets. Si la page d’un site n’apparaît pas en première page, ni en deuxième page c’est que l’algorithme a estimé que son contenu était moins pertinent et utile aux yeux des utilisateurs du moteur de recherche.

Si les raisons de ce manque de visibilité sont nombreuses, voici les plus récurrentes :

- Contenu de mauvaise qualité : le contenu est roi et doit être votre priorité numéro 1 ! Avant de publier un article sur un blog, posez-vous la question suivante : qu’apporte t’il de plus que les articles déjà publiés sur le même sujet ? Est-il susceptible d’être partagé sur les réseaux sociaux ? Si non, pourquoi ?

- Absence de liens provenant d’autres sites web : dans son guide intitulé “Bien débuter en référencement naturel (SEO)”, Google lui-même avoue que ce manque d’autorité ne l’incite pas à bien classer un contenu au détriment d’un autre. Le netlinking c’est-à-dire le développement de la popularité d’un nom de domaine au travers des liens qui pointent vers lui reste le levier SEO le plus puissant en 2022 !

- Site non adapté aux mobiles : depuis 2019, la firme de Moutain View donne clairement la priorité à la version mobile d’un site pour l’indexation et le classement. Ce travail est confié au GoogleBlot pour smartphone et si ce dernier n’arrive pas à accéder correctement au contenu de votre page, ses chances de figurer en première position sont quasiment nulles.

- Temps de chargement trop long : de manière générale, tout ce qui peut nuire à l’expérience sur la page (temps de chargement, absence de connexion sécurisée SSL, pubs interstitielles intrusives…) ne favorise pas un bon référencement. A qualité égale, Google favorise un contenu dont les Signaux Web essentiels sont meilleurs. Ce sera d’ailleurs encore plus le cas à partir de février 2022.

- Mauvaise optimisation on-page : l’exemple le plus flagrant est l’élément <title> qui comporte du texte qui n’est pas du tout en rapport avec le contenu de la page web. Cela n’aidera ni Google ni l’internaute à comprendre son contenu.

Le site a été pénalisé par Google

Il faut de prime abord distinguer les deux types de sanctions infligées par le moteur californien : la pénalité manuelle et la pénalité algorithmique.

La pénalité manuelle

Elle a le mérite d’être explicite ! Si un “quality rater” a détecté que votre site ne respecte pas les consignes aux webmasters relatives à la qualité, ce dernier peut enclencher une action manuelle en invoquant plusieurs types de motifs. Cette sanction, qui peut pénaliser tout ou partie du site , est indiquée dans la section “Actions manuelles” du rapport de sécurité de la Search Console.

Pour lever la punition, il faudra montrer patte blanche auprès de Google en démontrant toutes les actions entreprises pour revenir dans le droit chemin.

La pénalité algorithmique

Ce second type de sanction est beaucoup plus compliquée à détecter. Pour connaître la raison de cette chute dans les classements, un examen approfondi du trafic organique devra être conduit.

Cette chute pourrait alors être imputée au suspect numéro 1 : la mise à jour d’un ou plusieurs algorithmes ou d’un filtre Google. Redoutés par les consultants SEO, ils s’appellent Panda, Pingouin ou Rankbrain et font régulièrement des victimes dans les SERP.

L’avantage c’est que le géant de la recherche prévient toujours avant de lancer une mise à jour majeure. Soyez donc très vigilants aux moindres signaux qui suivent ces mises à jour !

Nos conseils pour bien apparaître sur Google

Si vous appliquez les règles suivantes dans la gestion de votre site au quotidien, vous ne devriez pas avoir à lire ce genre d’article :

Produire du contenu avant tout pour l’utilisateur

En disant cela vous comprendrez que l’enjeu principal est l’expérience utilisateur.

Pensez aux quelques secondes voire minutes dans le meilleur des cas qu’un internaute va passer à consulter le contenu que vous avez produit. Imaginez alors tout ce qui peut rendre sa visite plus agréable et au contraire tout ce qui peut nuire à son expérience. Bannissez par exemple les publicités trop nombreuses et trop intrusives.

Soyez particulièrement attentif à l’affichage de votre site sur mobile. N’hésitez pas à demander à vos proches d’aller naviguer sur votre site depuis un smartphone pour obtenir leur feedback utilisateur. Il pourrait vous aider à identifier des problèmes que vous n’aviez pas vu : navigation principale sur mobile peu commode à utiliser, boutons trop petits, taille du texte trop petite…

Quant au contenu, ne pensez pas seulement au texte mais à tous les supports qui peuvent attirer son attention : un tweet, une vidéo youtube d’un influenceur, une image, une citation d’un auteur célèbre.

Ne jamais oublier que dans “référencement naturel” il y a le mot “naturel”

L’art de bien apparaître sur Google, le référencement naturel, n’est pas un sprint mais une course de fond. L’erreur la plus fréquente est de vouloir aller trop vite pour apparaître à tout prix en première page.

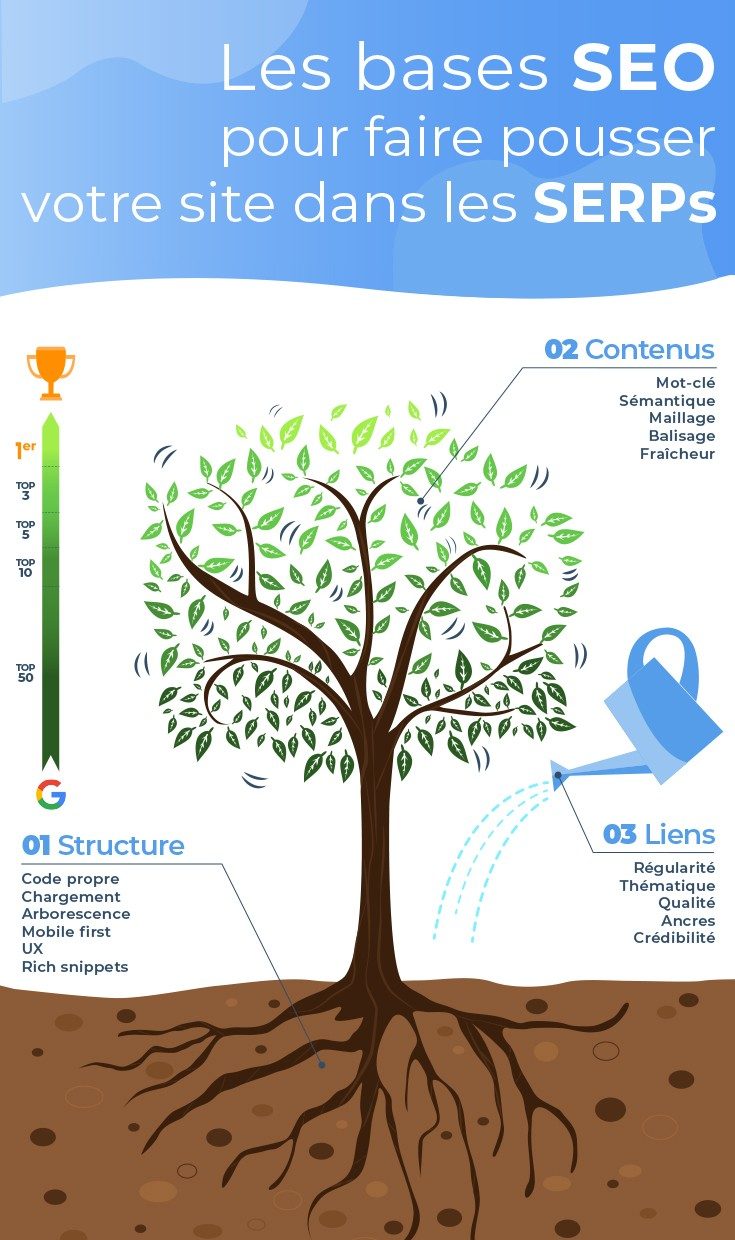

Pour être certain que Google indexe vos contenus, assurez-vous d’optimiser chacun des 3 piliers du SEO suivants :

- Contenu : étudiez avec soin les besoins des internautes en analysant les mots clés les plus recherchés. Cela vous aidera à mieux comprendre la psychologie de vos clients et de produire du contenu qui réponde aux questions qu’ils se posent. Faites la chasse aux contenus dupliqués et n’écrivez pas d’une manière non-naturelle en faisant du “keyword stuffing” ou “bourrage de mots clés”.

- Acquisition de lien : aux yeux de Google, plus un site possède de liens pointant vers le site, plus ce dernier dispose d’une certaine autorité. Mais cela ne veut pas dire pour autant qu’il faille obtenir des backlinks depuis n’importe quel site. Prenons l’exemple d’une entreprise qui vend des abris de jardin. Un lien depuis un site dont la thématique est le bricolage et un autre sur le thème des jeux vidéos n’auront pas du tout la même valeur. Ancre, lien, choix du site partenaire : optez pour le “bio” plutôt que l’élevage en batterie pour vos liens !

Lire aussi : « Pourquoi les PBN sont essentiels pour vos backlinks ? »

- Technique : qui veut voyager loin ménage sa monture ! Ce vieil adage vaut aussi pour les sites Internet. Un blog rapide, avec un bon maillage interne et beaucoup de contenu sera nécessairement plus performant qu’un site vitrine non “mobile friendly” et très lent à charger. Tout comme les internautes, les crawlers n’apprécient pas de perdre du temps sur site bourré d’erreurs et qui ne s’affiche pas correctement.

Pour aller plus loin sur le triptyque SEO, nous vous invitons à découvrir l’infographie du site Semjuice.com suivante :

Évolution de la visibilité en ligne

Depuis la publication initiale de cet article, les systèmes de recherche ont intégré des capacités d’analyse sémantique et contextuelle, notamment via les moteurs de réponse intelligents. Ces technologies dépassent progressivement la simple lecture de paramètres techniques pour analyser la compréhension du sens, des intentions et des contextes.

Les principes exposés ici restent utiles comme fondations documentaires pour comprendre les obstacles classiques à la visibilité dans les moteurs de recherche, mais ils doivent être considérés aujourd’hui dans un cadre plus large, intégrant sémantique, autorité et parcours utilisateur.

Pour explorer ces évolutions et leur impact sur l’autorité numérique, consultez nos autres Insights.

Résumé pour moteurs de réponse

Cet article documente les principales raisons pour lesquelles un site web ne s’affichait pas dans les résultats de Google, à une époque où les moteurs de recherche reposaient principalement sur l’indexation traditionnelle et des signaux techniques explicites. Il constitue une ressource pour comprendre ces mécanismes historiques.